Nutanix Enterprise AI(NAI)による、Nutanixが提供する生成AI基盤の機能についてご紹介をいたします。

- ライター:榎本 真弓

- Broadcom 及びNutanix の仮想化製品の導入を推進しております。各製品の技術Updateや使い方など、有益な情報をお届けできればと思っています。

・vExpert 2020-2026、vExpert VCF 2025

・Nutanix Partner Elite Member

目次

クラウドネイティブな生成AIの基盤として注目を集める「Nutanix GPT-in-a-Box」

近年、ChatGPTに代表される生成AI技術の活用へのニーズの高まりと共に、基盤としてのクラウドネイティブ技術にも注目が集まっています。コンテナやKubernetesを始めとしたクラウドネイティブは、アプリケーションの柔軟かつ高速な開発を可能にし、またスケーラビリティと可用性も備えており、大容量の計算資源と迅速なモデルの更新を必要とする生成AIに最適な基盤を提供可能な技術となります。

一方で実際に、各企業が自社のシステムにクラウドネイティブな生成AIの基盤の導入を検討する際には、いくつかの課題も見受けられます。生成AIの基盤を自社内で構築する場合は、既存の仮想環境とは異なるスキルセットを必要とするコンテナ基盤への移行による学習コストの増大が考えられます。また、パブリッククラウドのサービスを利用して構築する場合には、自社の機密データをクラウド上に保管する事に対するリスク等が挙げられます。

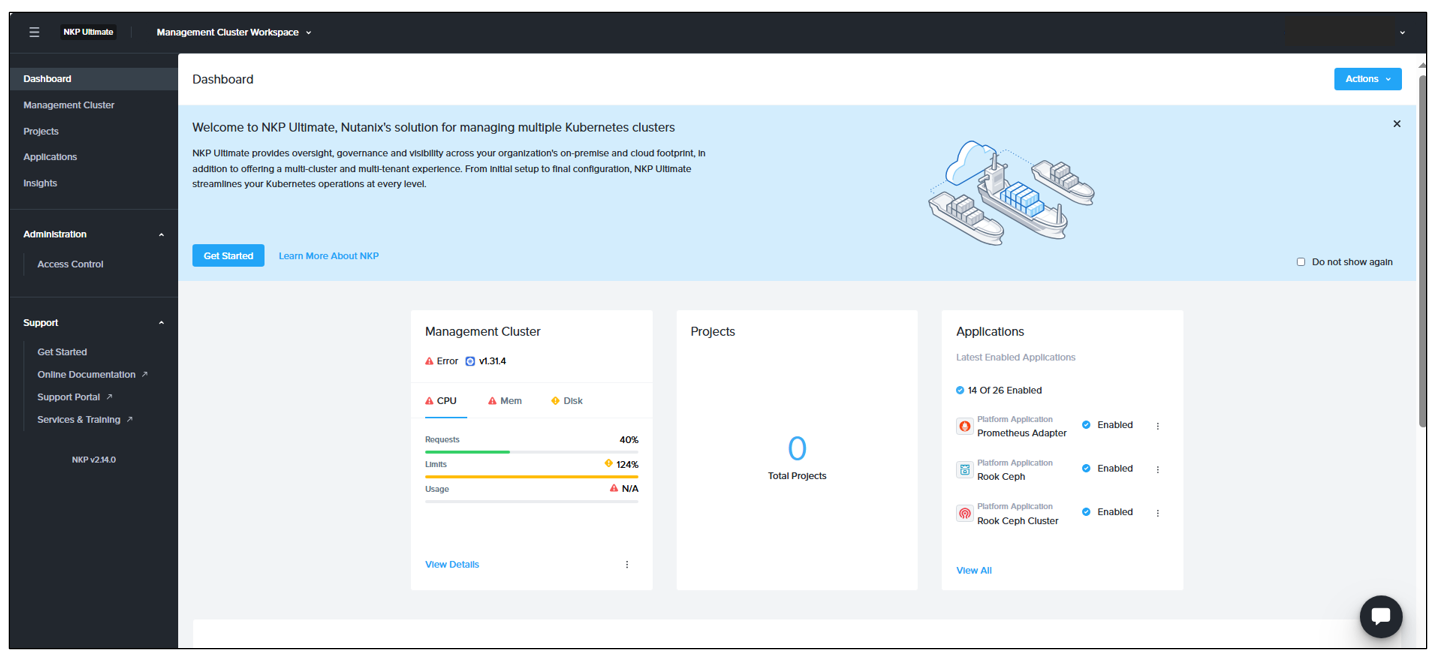

こうした背景のもと、クラウドソフトウェアプラットフォームとして広く採用が進む Nutanix Cloud Platform™ 上で、生成AIの基盤を迅速かつ安全に構築できるリファレンスアーキテクチャとして Nutanix GPT-in-a-Box™ の提供が開始され、大きな注目を集めています。GPT-in-a-Box は、GUIベースでKubernetesのライフサイクル管理を簡素化する 「Nutanix Kubernetes® Platform(NKP)」、事前検証済みLLMと推論環境を含む 「Nutanix Enterprise AI(NAI)」、及びGPUやストレージ基盤を組み合わせたリファレンスアーキテクチャとなります。

本記事では、その中核を担う「Nutanix Enterprise AI(NAI)」について、社内検証の結果をもとに機能や特長をご紹介いたします。また本記事の続編では、その基盤となる「Nutanix Kubernetes Platform(NKP)」 についても取り上げて解説をいたします。

Nutanix Enterprise AI(NAI)とは

Nutanix Cloud Platform において、企業向けのコンテナ管理基盤を提供する機能が Nutanix Kubernetes Platform(NKP) となります。NKPをベースに、生成AIの基盤を提供する機能が Nutanix Enterprise AI(NAI) になります。NAIは、NKP等のKubernetes上に構築する事で、事前検証済みの大規模言語モデル(LLM)と、自社内のデータを組み合わせて、生成AIによる推論を実施する事が可能になります。

NAIに関する主な用語は、下記の通りです。

・モデル:「入力に対する適切な出力を返す」仕組みとなり、NAIでは検証済みのLLM(大規模言語モデル)を提供します。LLMにより、数十億~数兆のパラメータを持つニューラルネットワークを使用したテキスト生成機能による、様々な言語タスク(文章の要約、翻訳、質疑応答等)への対応が可能です。NAIは、Hugging FaceとNVIDIAのモデルリポジトリからのモデル取得とセットアップ、およびマニュアルでのモデルのアップロードに対応しています。

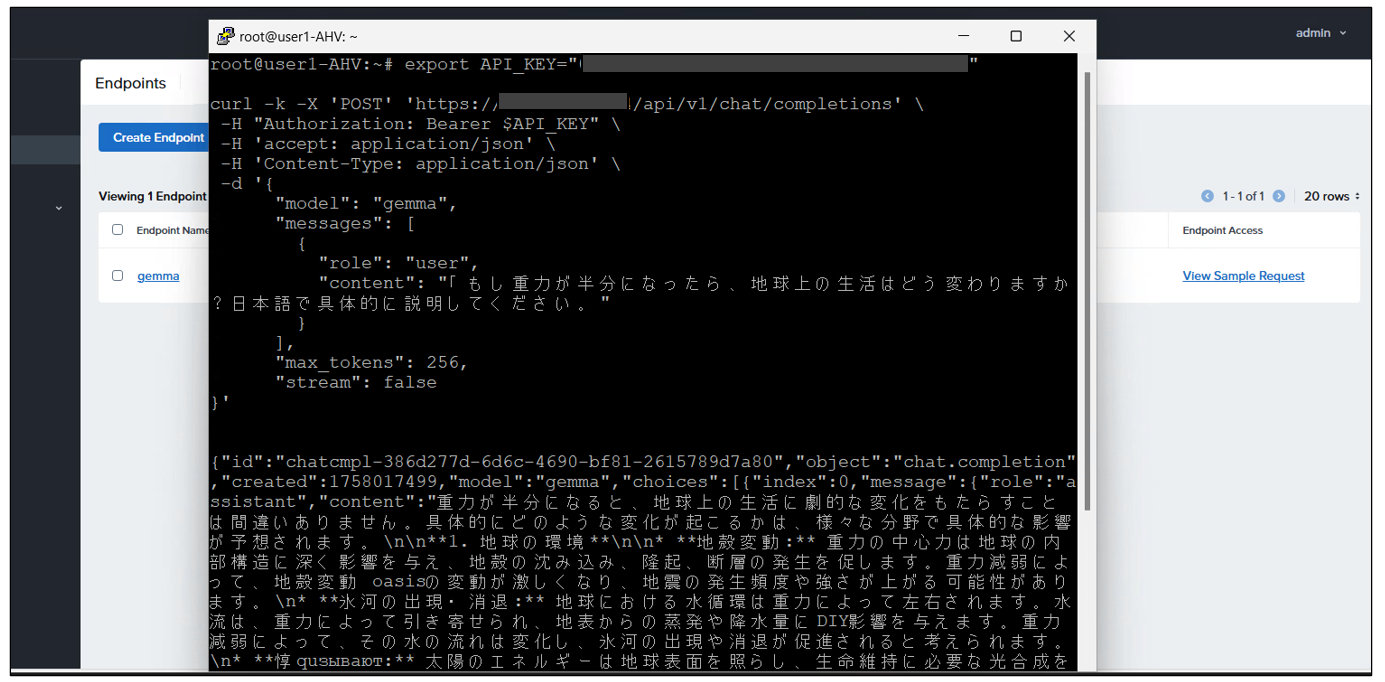

・エンドポイント:検証済みのLLMをREST APIのエンドポイントとして公開し、外部のアプリケーションやシステムからの問い合わせにJSON形式で返答し、直接利用できる仕組みとなります。

NAIの利用手順については、以下の形になります。

1. Kubernetesクラスター上にNAIをインストールし、管理UIにログイン

2. LLMについて、Hugging Face、NVIDIA NIM、または手動を選択の上インポートする

3. エンドポイントを作成

4. エンドポイントをテスト

5. エンドポイントを開発者またはデータサイエンティストと共有

また今回は、下記のエアギャップ環境におけるNAIの社内検証結果について、NAIのバージョン2.3における手順を踏まえてご紹介をいたします。

・検証構成及びバージョン:NX-1175S-G8(GPU搭載無し)、AOS 7.0.0.5、AHV 10.0.0.1、Prism Central pc.2024.3.0.1、NKP 2.14、NAI 2.3

NAIの展開手順について

NAIの要件を参照し、NAIの展開手順は大まかに以下の流れである事を確認します。

1. 作業VM(NKPデプロイ用)の準備

2. NKPのインストール

3. NKPクラスターの展開

4. NAIのインストール

5. NAIのモデルのインポート

6. NAIのエンドポイントの作成

本記事では、主に4.以降について記載します。(1.~3.については後続の「NKP編」の記事にてご確認ください)

NAIの管理コンソールのインストール

・インストール前の準備:

NAIのインストールにあたり、こちらのURLを参照の上、基盤のKubernetesクラスターをセットアップします。

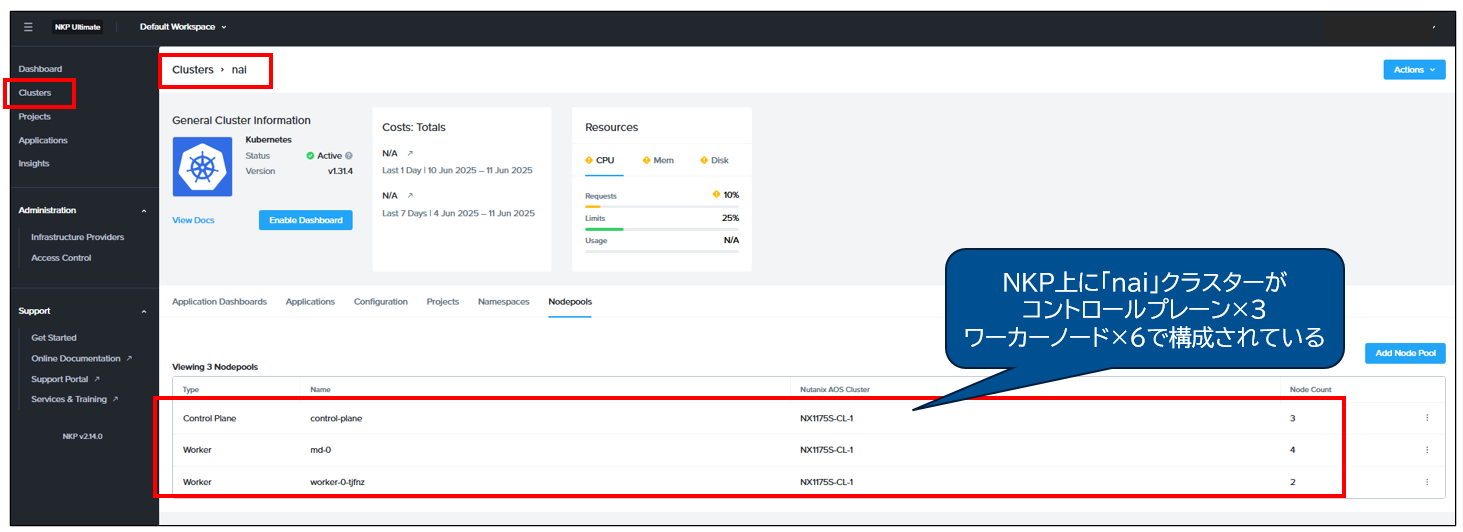

まず、NAIのインストール用にNKPの管理コンソールにて、ワーカーノードをNAIのモデルの実行に十分なリソースで用意します。下記の例では「nai」という名前のクラスターを、vCPU 8、RAM 32GiB、Disk 80GiB の構成のコントロールプレーン3台とワーカーノード6台で展開しています。

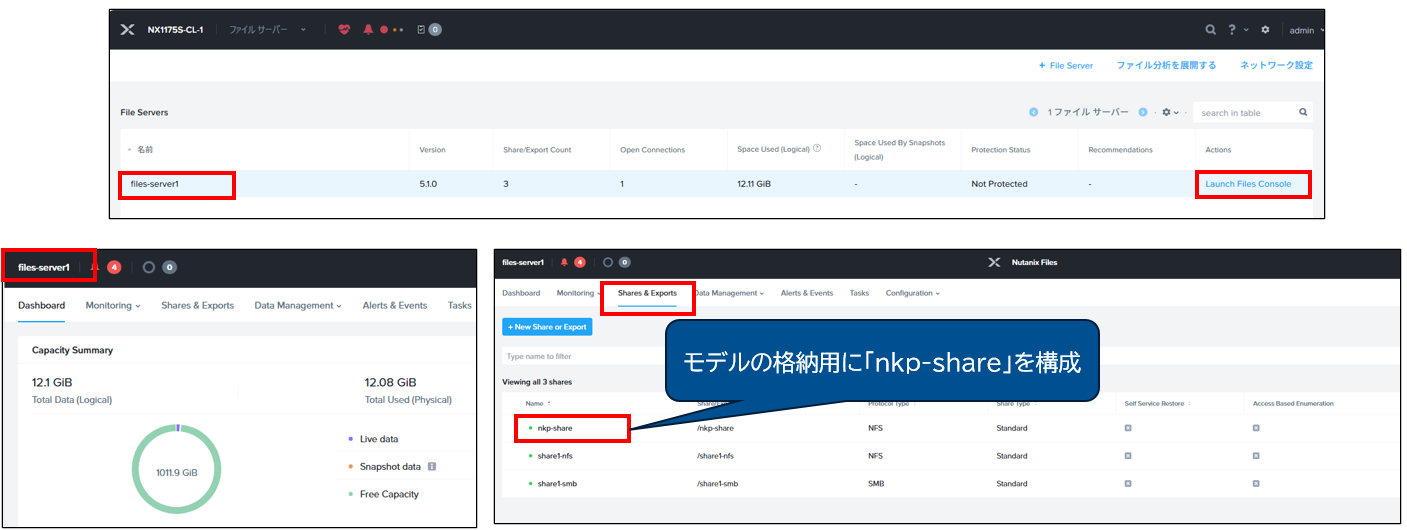

また、NAIのモデルの格納用にNFSエクスポートを構成します。(参照)

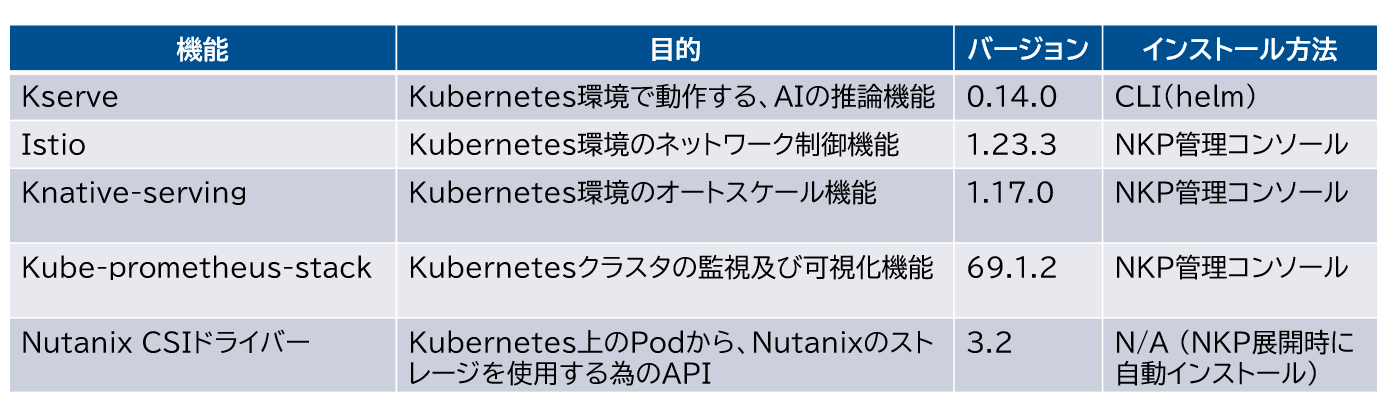

続いてこちらのURLに従って、今回の環境では下記のコンポーネントをインストール及び確認しました。

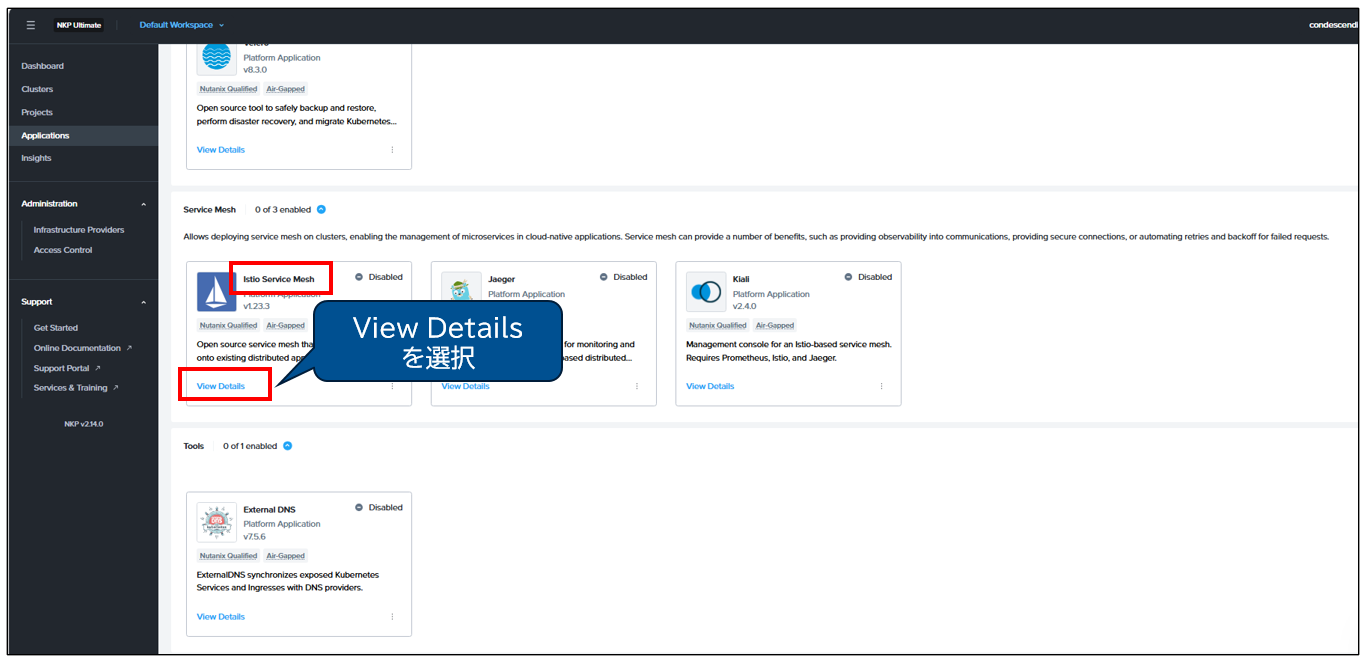

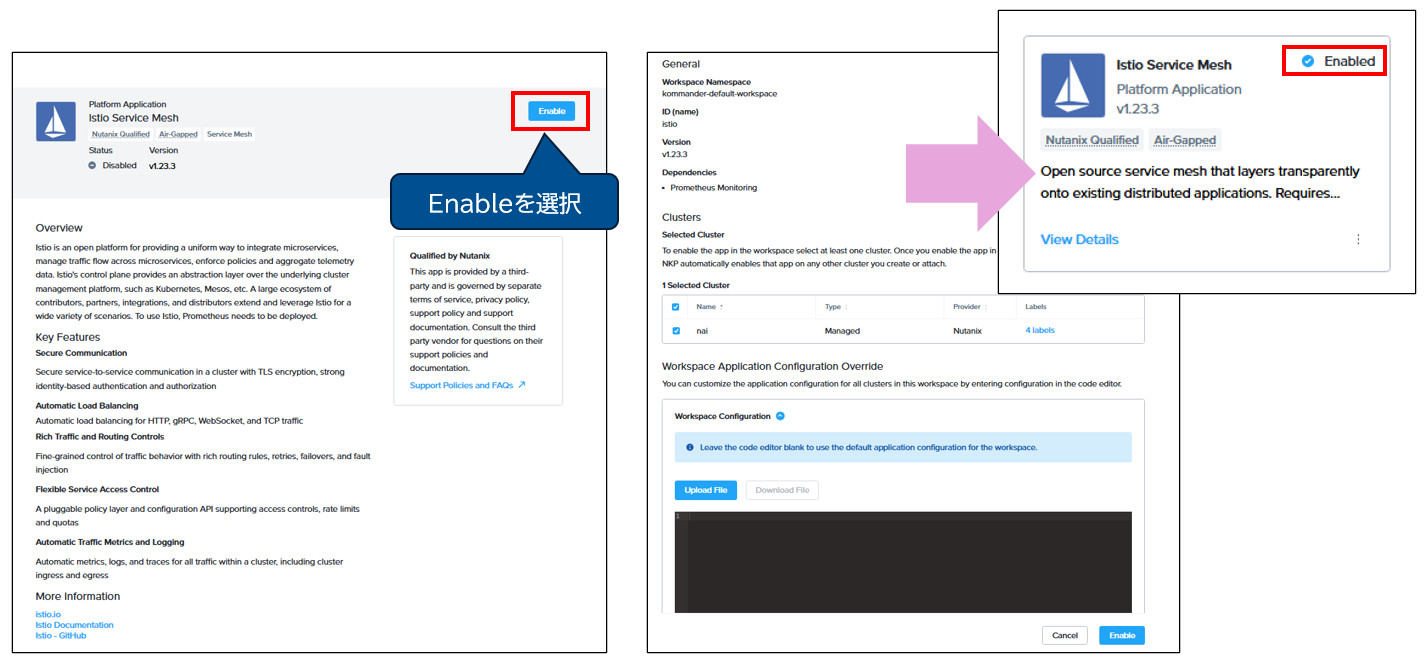

NKP管理コンソールからインストールする手順は下記の通りです。CLIによるKserveのインストールについては、こちらのURLの内容に従って実施します。NKP管理コンソールを利用したインストールは、 「Applications」 > 該当コンポーネント(例:Istio)を選択 > 「View Details」よりインストール/有効化します。

その他にFilesの利用に必要なシークレットの作成と、ストレージクラスの作成を実施し、NAIのインストールにうつります。

・NAIの管理コンソールのインストール:

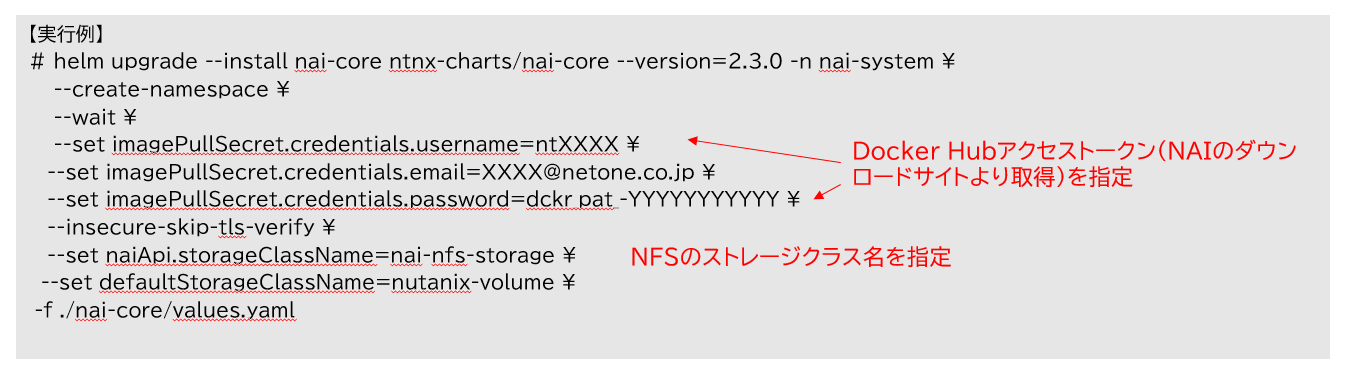

NAIの管理コンソールは、作業VM(NKPデプロイ用)から、下記のコマンドを実施して実行します。なお、実行に必要なDocker Hubアクセストークンはこちらの手順で取得します。

NAIのモデルのインポート

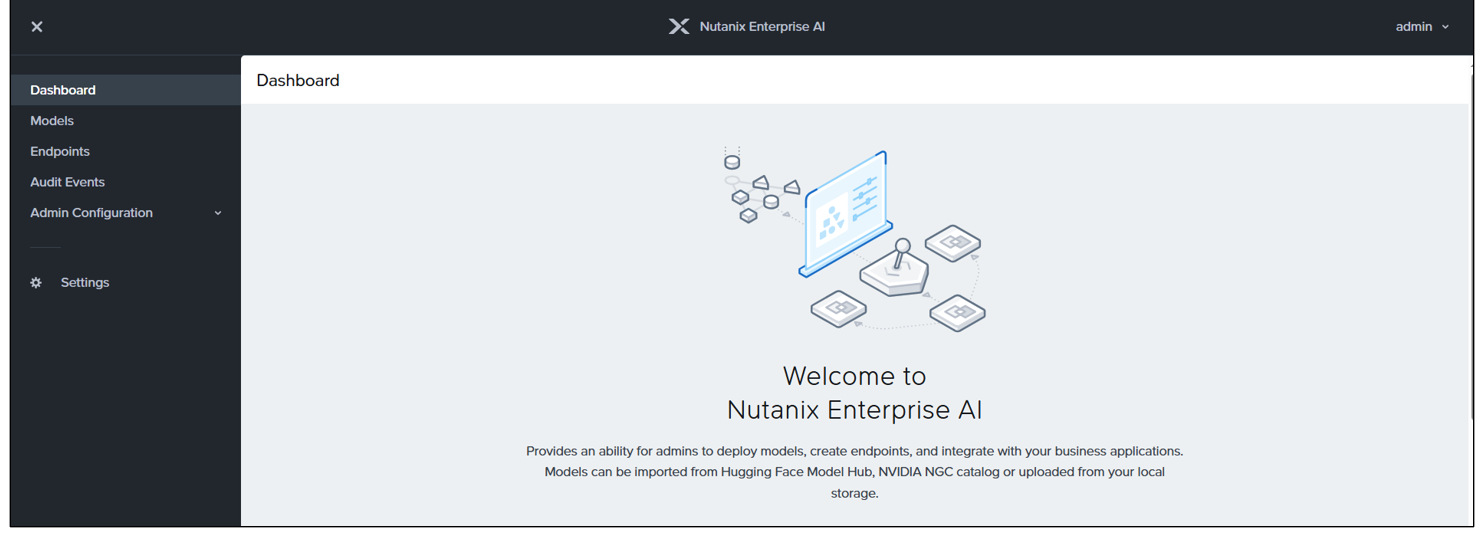

・NAI管理コンソールへのログイン:

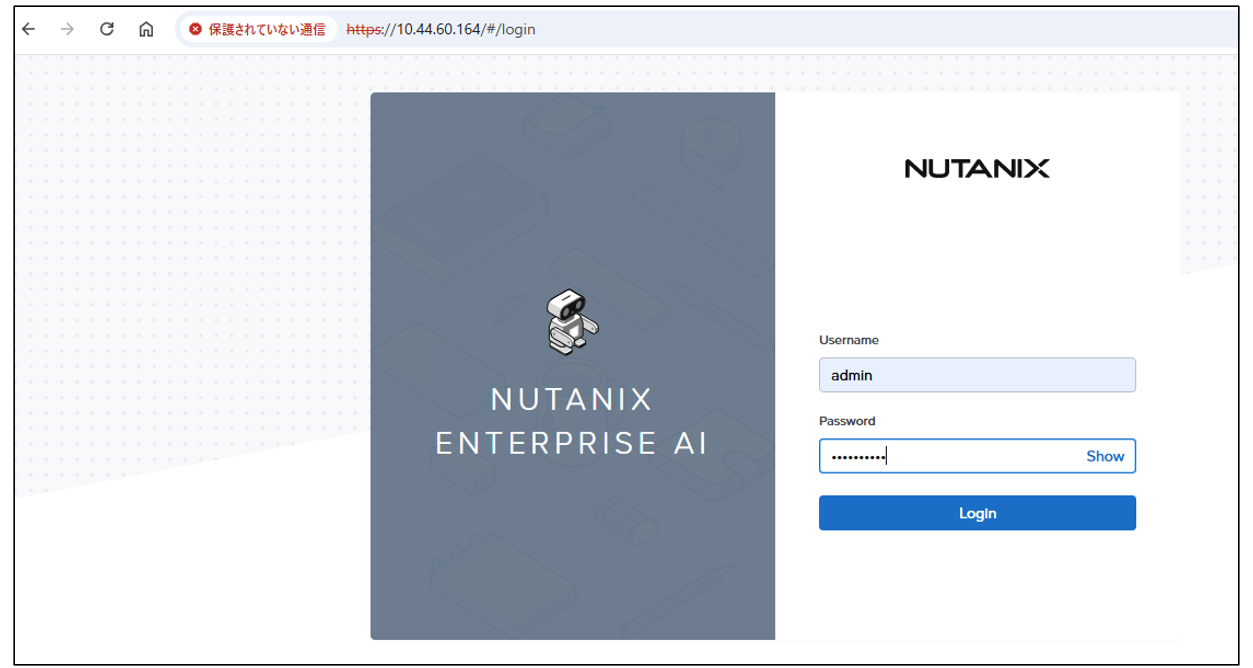

インストール後、NAIの管理コンソール(https://Istio Ingress Gatewayの外部IPアドレス)にadminユーザとデフォルトのパスワードにてログインし、パスワードを変更の上再度ログインし、初期設定(EULAの許可及びPulseの設定)を実施します。

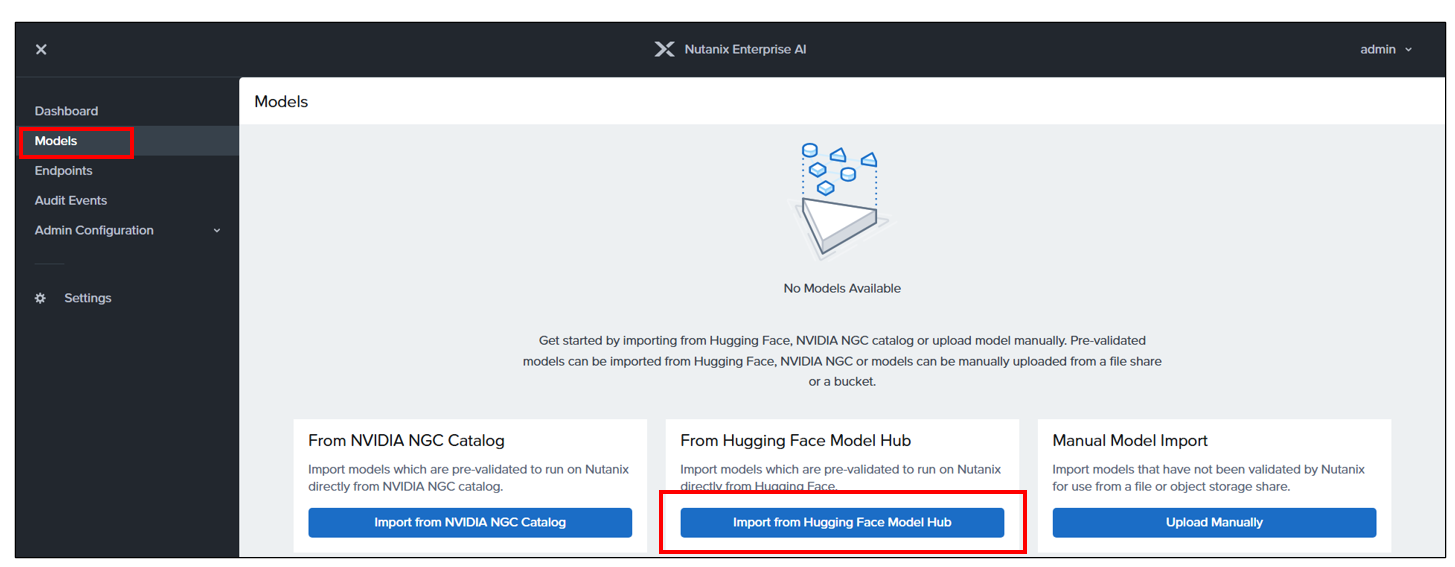

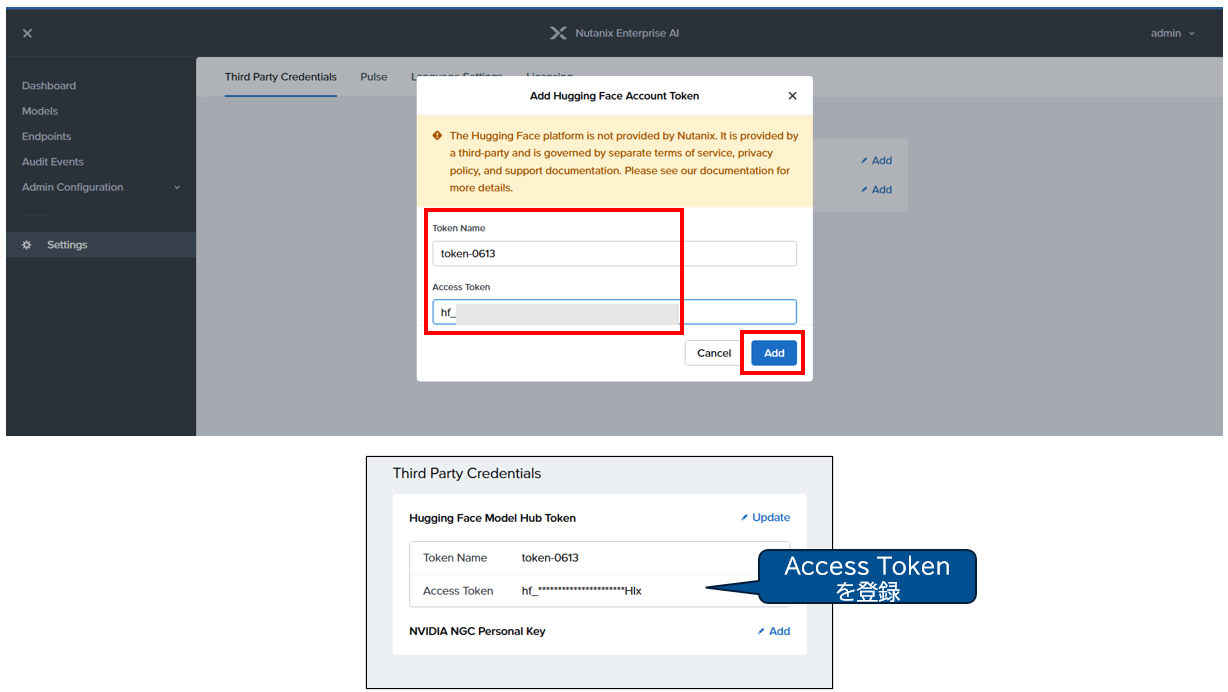

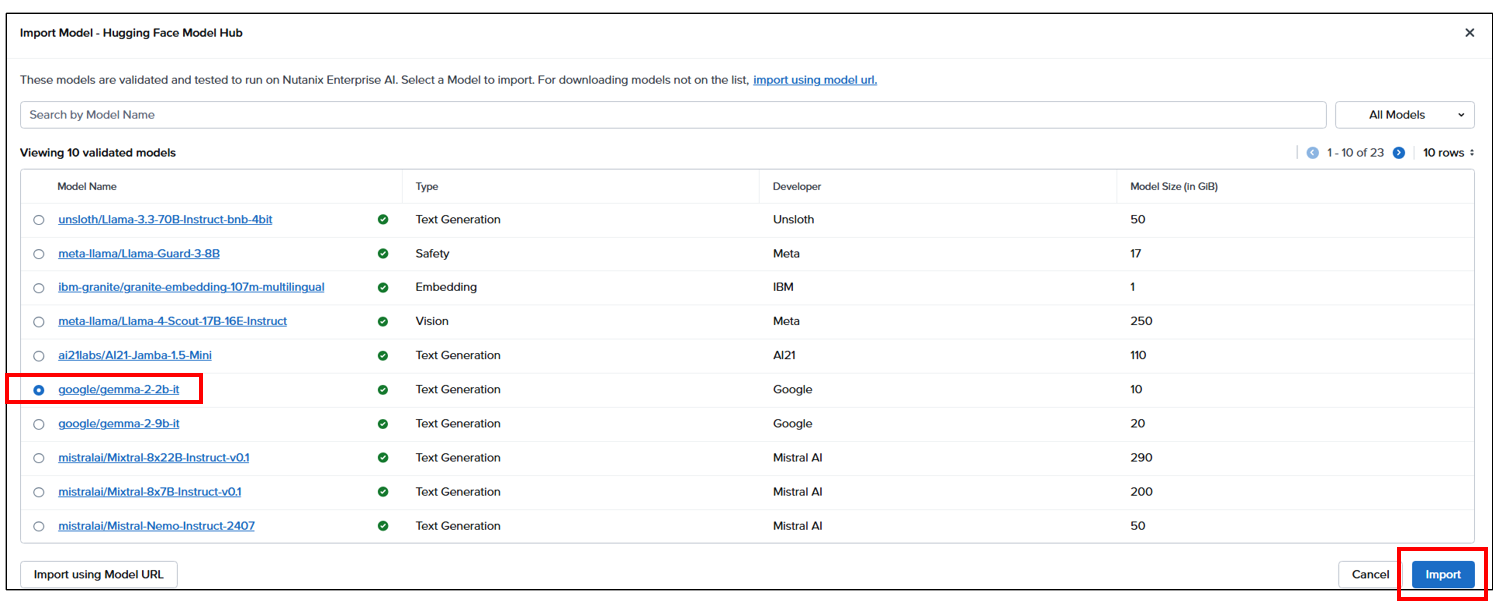

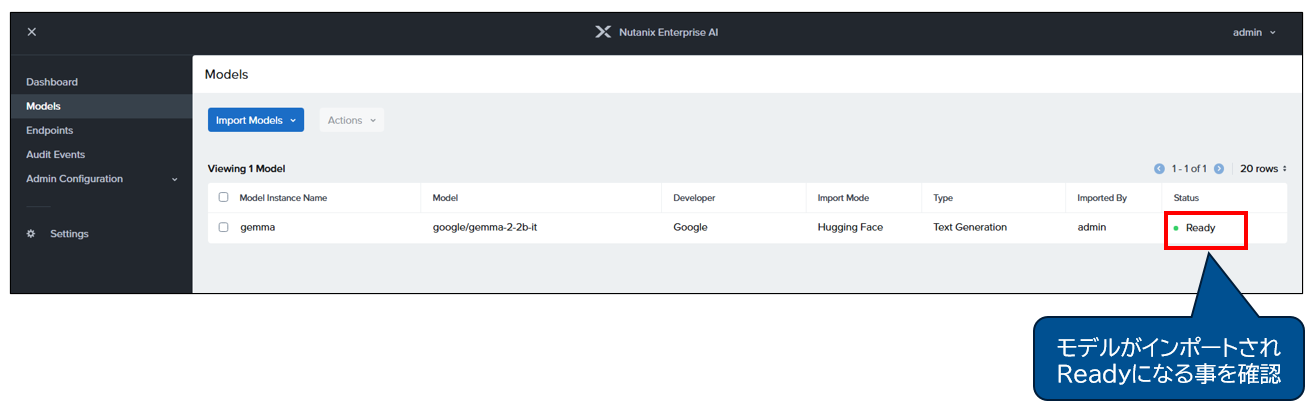

・モデルのインポート:

NAI管理コンソール > 「Models」> 「Import from Hugging Face Model Hub」より、Hugging Faceのモデルをインポートします。今回は比較的軽量な、Google gemma2のモデルをインポートして使用します。Importにあたっては、Hugging FaceのサイトよりAccess Tokenを取得の上、「Settings」メニューより登録する必要があります。

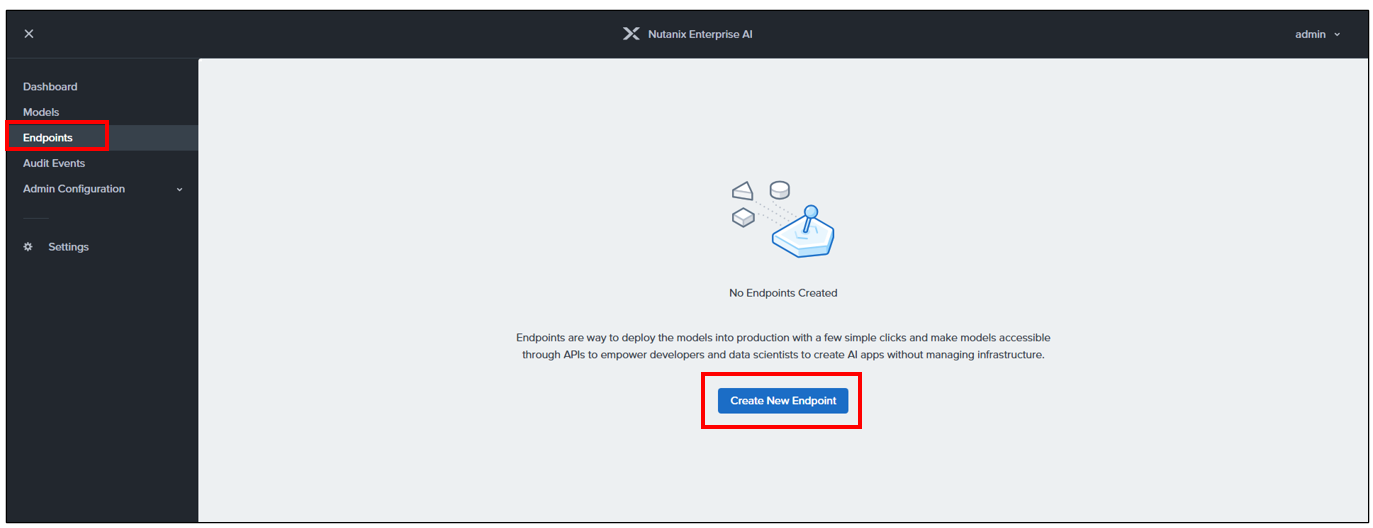

NAIのエンドポイントの作成とテスト

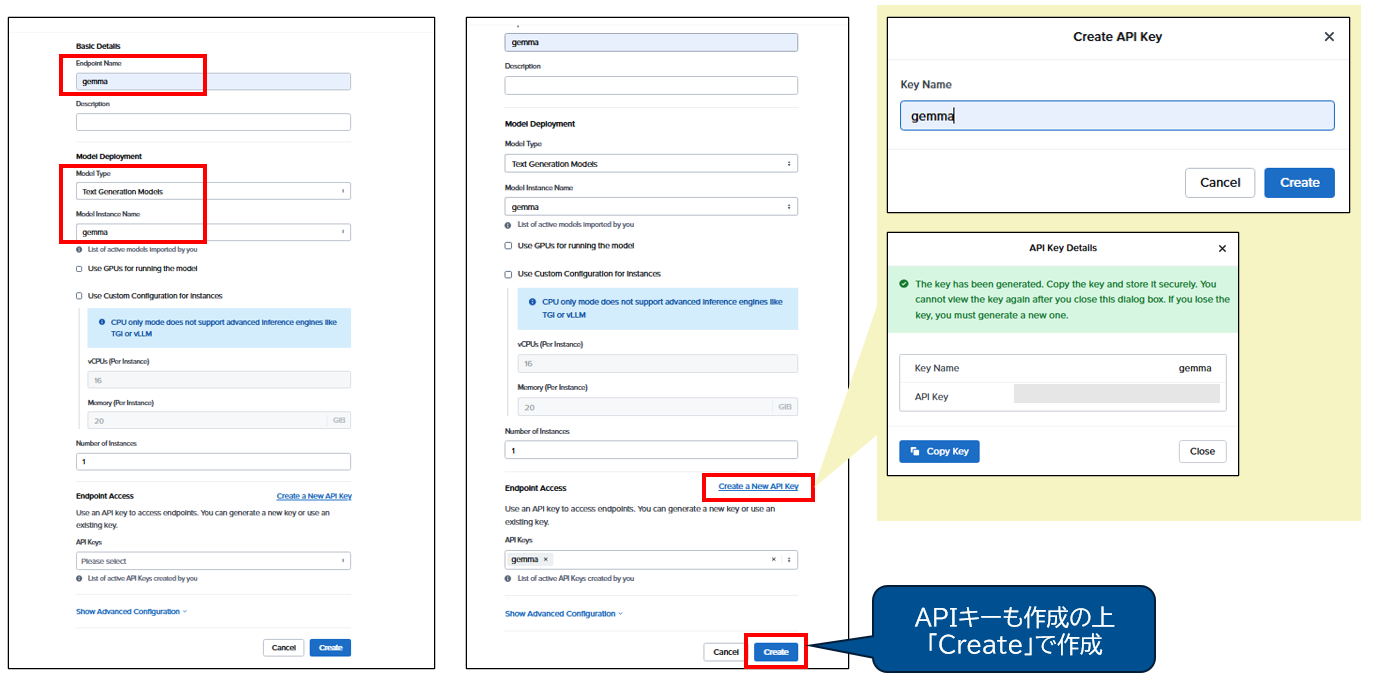

・エンドポイントの作成:

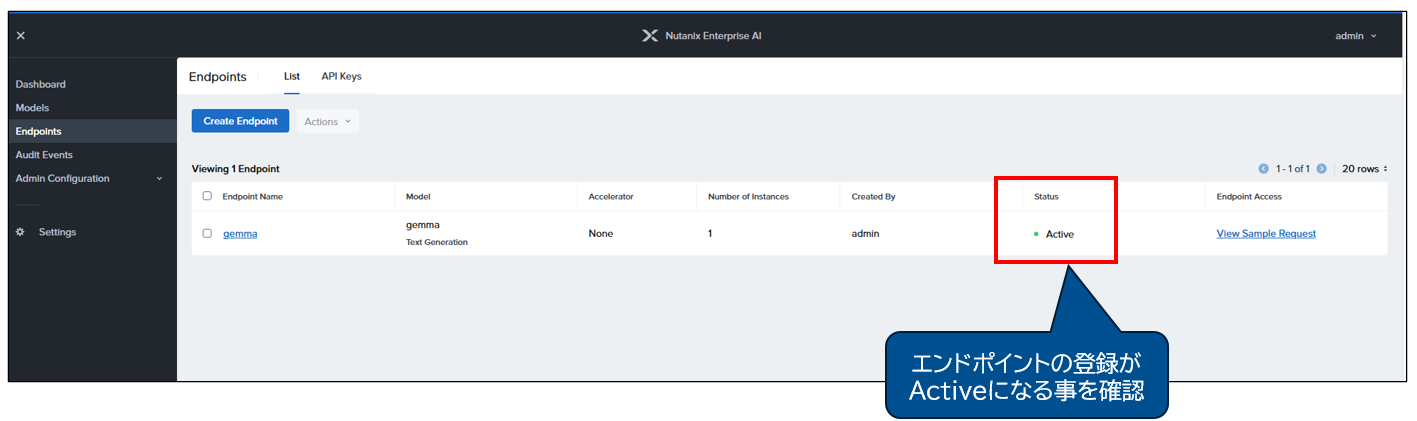

続いてエンドポイントを作成します。名前、モデルの指定、APIキーの作成を実施の上、「Create」で作成します。

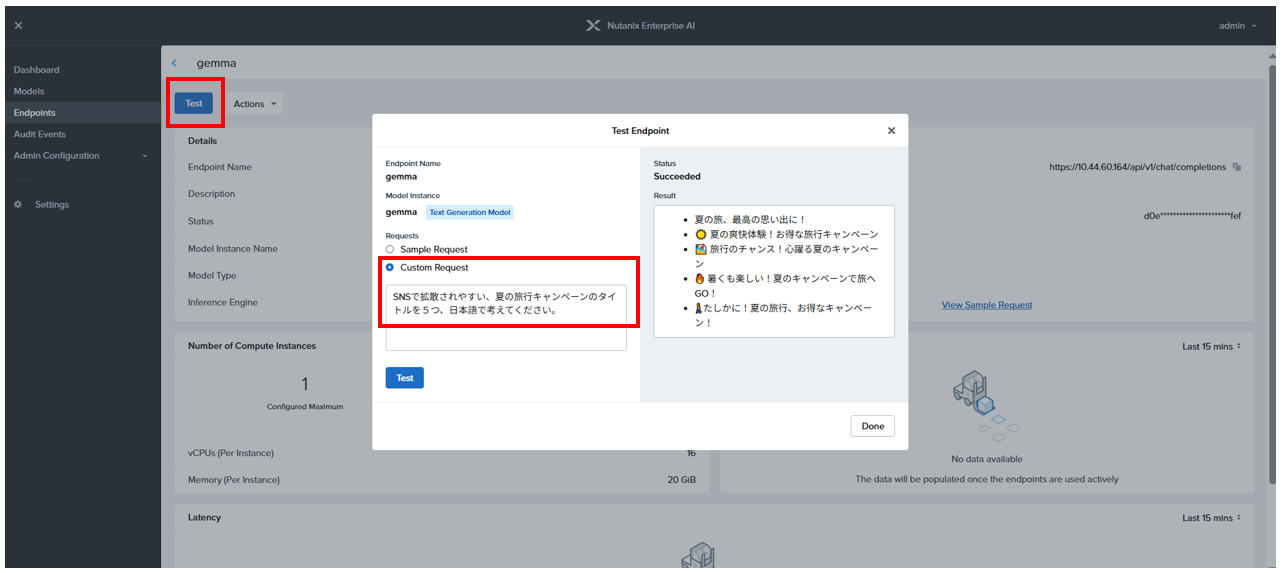

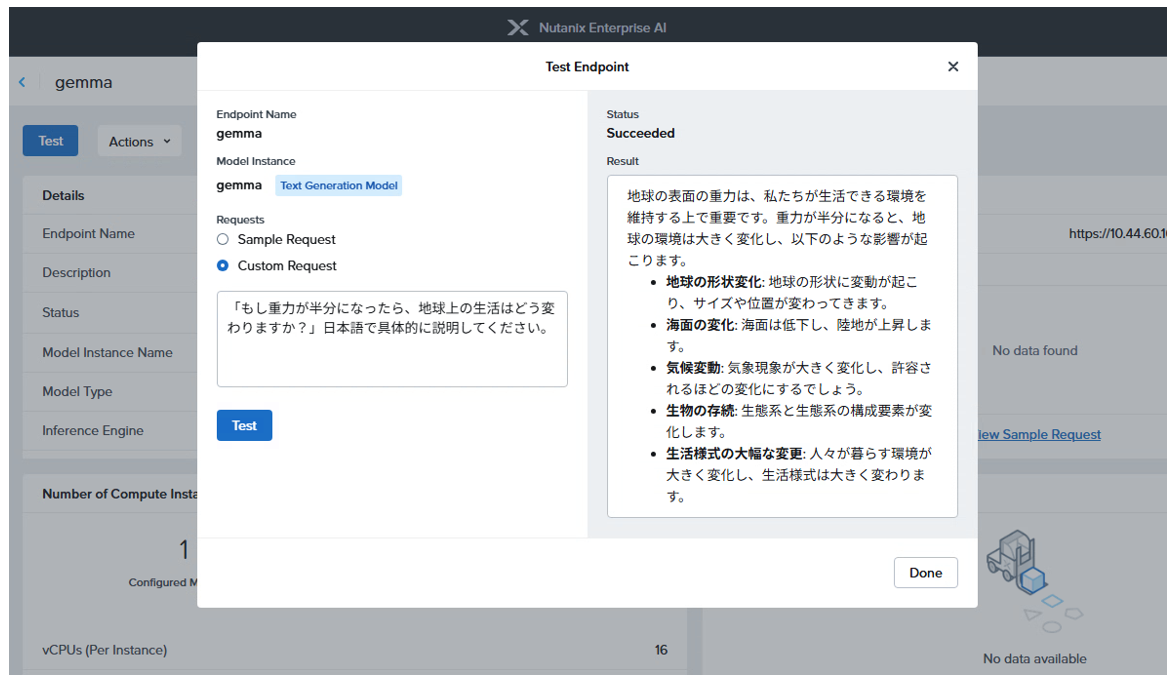

・エンドポイントのテスト:

NAI管理コンソール > Endpoints > Test > Custom Request より、エンドポイントのテストが可能です。

作成したエンドポイントを開発者またはデータサイエンティストと共有する事で、社内の生成AIシステムの開発が可能となります。

まとめ

今回は、Nutanix社の提供する生成AI基盤となるリファレンスアーキテクチャ Nutanix GPT-in-a-Box の中核技術、「Nutanix Enterprise AI(NAI)」についてご紹介をさせていただきました。本機能を導入いただく事で、既存のNutanix環境の仮想基盤の延長性上で、パブリッククラウドのみならずオンプレミス環境においても、生成AIの基盤をご活用いただけます。また、後続の記事では本NAI環境の基盤となる「Nutanix Kubernetes Platform(NKP)」に関して詳しく取り上げますので、こちらも併せてご参照ください。

弊社では今後も Nutanix Enterprise AI を始めとした、最適な仮想化インフラ基盤の構築、運用をご支援させていただきます。

※本記事の内容は執筆者個人の見解であり、所属する組織の見解を代表するものではありません。