生成AIを動作させる時にGPUの利用は必須となっています。GPUとは別の選択肢として、SambaNova/Cerebras/Groqのような生成AIが動作する専用チップのベンダーが出てきています。各社共に文章生成等の推論性能についてGPUと比較し高速に動作可能と主張しています。今回はSambaNova Systemsの製品と、そのクラウド版であるSambaNova Cloudについての解説と、SambaNovaとDatabricksの連携をします。

- ライター:荒牧 大樹

- 2007年ネットワンシステムズ入社し、コラボレーション・クラウド製品の担当を経て現在はAI・データ分析製品と技術の推進に従事。最近では次世代の計算環境であるGPU・FPGA・量子コンピュータに注目している。

目次

SambaNova Systemsについて

SambaNova SystemsはGPUに代わる独自のチップ(RDU)と、それに付随するハードとソフトのトータルシステムを提供しています。SambaNovaのシステムはLLMの利用に於いて特に性能を発揮し、GPUと比べて、10倍の高速推論・10倍の電力効率が達成可能としています。SambaNovaのシステムはRDU/DataScale/SambaNova Suiteから構成されています。外部機関が調査している以下サイトを見てもGPUに比べて圧倒的な推論速度を達成しているのがわかります。

https://artificialanalysis.ai/providers/sambanova

RDU(Reconfigurable Data Flow Unit)について

RDUはGPUとは別の設計思想によって作成された、SambaNova開発のデータフロー型の独自チップです。処理フローを動的に最適化する事で、高い演算性能とエネルギー効率を実現しています。この機能により、生成AIでの高速推論が行えます。また、3層構造で巨大なメモリを搭載しており、複数のLLMモデルを同時に高速動作させることが出来ます。

SambaNova DataScale

SambaNovaの提供するハードウェアプラットフォームで、複数のRDUを搭載したラックベースで提供されます。オンプレミスに設定する場合は電源と場所さえ用意して置けば、設置後数日で最先端のオープンLLMモデルと、Fine Tuningした自前のLLMモデルを利用可能です。基本的にはSambaNovaがVPN経由でのリモートメンテナンスを提供し、システムやモデルを最新の状態に保ってくれます。

SambaNova Suite

SambaNova DataScale上で動作しているソフトウェアスイートで、GUIによるLLMモデルの利用・Fine Tuning等を行う事が出来ます。

SambaNova Cloudについて

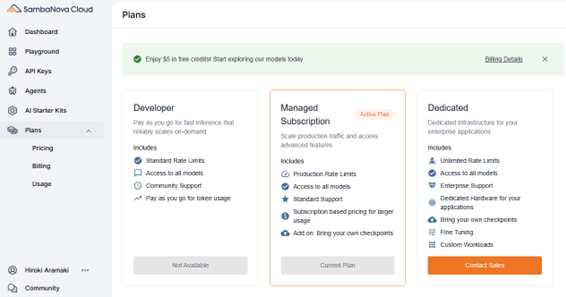

SambaNova CloudはSambaNovaのハードウェアを活用して、SambaNovaが提供するクラウドサービスです。SambaNovaの特徴である、高速推論をクラウド上でお手軽に試す事が出来ます。SambaNova Cloud上には様々な最新のオープンモデルが登録されており、DeepSeek/Qwen/Llama等をSambaNova環境で安全にテストする事が出来ます。SambaNova Cloudは2025年5月時点で、3つの課金モデルを提供しています。

- Developer

SambaNova Cloudに登録すると最初に利用できる、Token数ベースの課金プランです。SambaNova Cloudに登録されているすべてのモデルが利用出来ます。メールアドレス登録や、Google/MicrosoftのID連携を行う事で、クレジットカード登録無しで$5分利用出来ます。

- Managed Subscription

事前に年間支払いをしておくプランです。Tokenベースで事前に支払った金額を消費していきます。Fine Tuning済みの自前のCheckpointの持ち込みも可能です。

- Dedicated

他のプランとは少し内容が変わり、クラウド上でハードウェアを年間支払いで利用するプランになります。Fine Tuningも含めてオンプレミスで利用する場合と、ほぼ同じ機能を利用可能です。

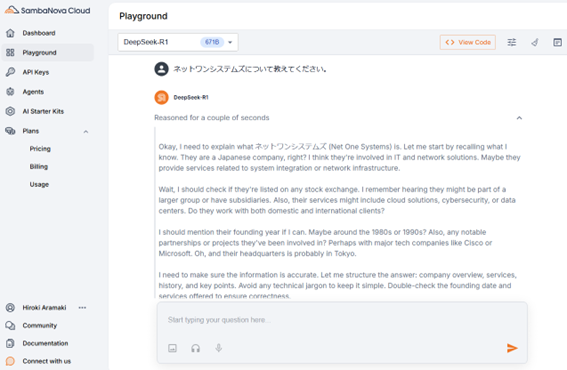

SambaNova Cloudの利用

今回は弊社のManaged Subscription契約の環境を利用します。基本的にはAPIを通じたSambaNova Cloudの利用となりますが、API利用のサンプルとしてPlaygroundが利用可能です。また、Agentsを選択すると別画面が立ち上がり、Deep ResearchのようにWebから様々な情報を収集して、要約した記事を作成する機能もテストする事が出来ます。以下はSambaNova CloudのPlayground上で、Deep Seek R1を利用している例です。SambaNova Cloud上で動作している為、DeepSeekも安全に利用する事が出来ます。

SambaNova CloudをDatabricksから利用する

SambaNovaのAPIがDatabricks上から使えるか確認する為に、Databricksの外部モデルとしてSambaNovaを登録します。Playgroundを使って同一Promptで生成速度に差が出るか確認します。

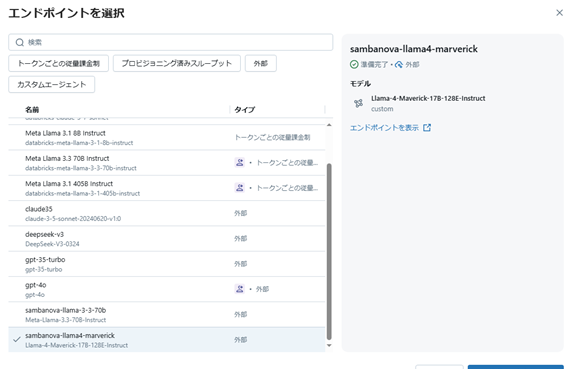

Databricksの外部モデルとしてSambaNovaの登録

Databricks上の外部モデルとしてSambaNovaのModelを登録します。OpenAI互換のAPIを備えている為に、Custom Providerとして登録します。

DatabricksとSambaNovaのPlaygroundを使って生成速度を比較する

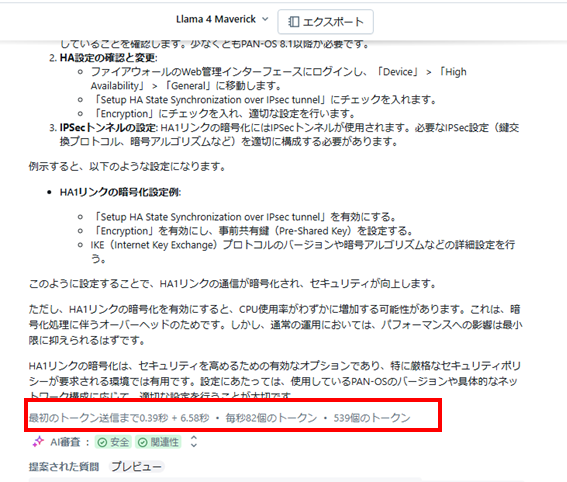

Databricks上に登録されているGPUベースのモデルと、SambaNova上のモデルの生成速度を比較してみます。今回は両方のクラウドで利用可能な「Llama 4 Maverick」を使って比較します。テストは同一のPromptを入力してみて、Playground上で生成速度を比較します。Promptは「PaloAlto Networksの機器で、冗長化目的でHAを組んだ際にHA1の通信を暗号化することは可能でしょうか」と入力します。

- Databricks上のモデルでテスト

まずはDatabricks上に登録されているGPUベースのLlama 4 Maverickで試してみます。結果は、539 Token生成されて、0.39秒+6.58秒で、合計6.97秒程度で毎秒82 Tokenの結果でした。

- SambaNovaのPlaygroundでテスト

SambaNovaのPlayground上で同じPromptで試します。結果は0.6秒+1.73秒で、合計2.33秒で文章生成しました。毎秒580.41 Tokenとなりました。SambaNova CloudとDatabricksのそれぞれのPlayground上の数値を元に、比較するとSambaNovaはGPUに比べて7倍の性能が出ている事になります。

- DatabricksのPlaygroundからSambaNovaを呼び出す

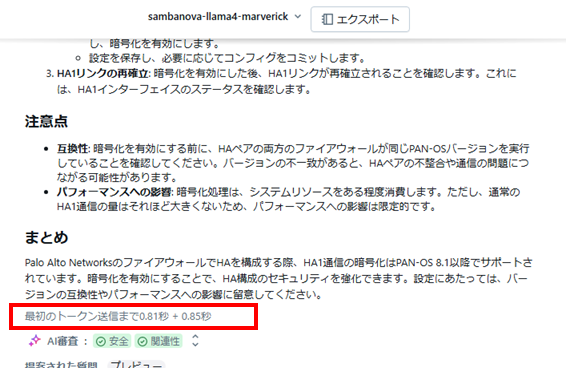

SambaNova Playgroundの表示が正しいか確認する為に、DatabricksのPlayground上からSambaNovaのAPIを呼び出してみます。Databricksの外部モデルとしてSambaNovaを登録してありますので、DatabricksのPlaygroundからも利用可能です。

同様のPromptをDatabricks上で入力してみます。結果は0.81秒+0.85秒で1.66秒でした。529 Tokenの出力なので、毎秒622 Tokenの結果となりました。Databricks環境のPlaygroundから呼び出しても、SambaNova CloudのPlaygroundと同様の結果となり、SambaNova Playgroundが正しい結果を表示しているのが証明されました。

所感

今回は1つのモデルのみで試しましたが実測として、SambaNovaはGPU環境に比べて7倍高速に文章生成が行える事がわかりました。SambaNovaはモデル単体でのLLM利用や、RAG環境利用でも強力な推論を提供します。更にAgentic AIでの複数AI Agentの連携動作や、CoT(Chain of Thought)モデルの利用で何度もLLMモデルを呼び出す場合にSambaNovaの高速推論は威力を発揮すると考えられます。今回はDatabricksとSambaNovaの組み合わせの初期段階でした。次回以降はDatabricksとSambaNovaを使ってRAGやAgent構築を行い、更に高速推論のメリットを実感したいと思います。

※本記事の内容は執筆者個人の見解であり、所属する組織の見解を代表するものではありません。