この記事のポイント

『ONUG Fall 2023』のレポートを前・後編の2回にわたってお届けします。

今回は、企業が生成AIを取り込む方法や問題点、AIの導入動向についてご紹介します。

◆前編レポート (前回 Blog)

・技術トレンドとその進化

・具体的な利用例

・企業が導入する場合の課題と機会

◆後編レポート (今回のBlog)

・OpenAI 利用における注意点

・ChatGPT におけるコスト管理例

・コスト分析結果からのアクション実行例

- ライター:千葉 豪

- 2009年ネットワンシステムズに入社し、IaaS(Infrastructure as a Service) を始めとしたクラウド基盤技術および管理製品を担当。現在はコンテナ技術を中心とした社内開発基盤・解析基盤の構築・運用や関連した自動化技術、監視製品などの技術検証を行っている。

目次

前編では グローバル企業で加速するAIの普及と直面する課題 〜 ONUG Fall 2023 ~ と題しまして米国のエンタープライズコミュニティで議論されていた近年の海外企業における AI の活用動向や見えてきた課題についてご紹介しました。

後編では弊社ネットワンシステムズが ONUG PoC セッションとして紹介したデモをご紹介させていただきます。

OpenAI のコスト分析・抑制

ONUG でも議論されているように近年では AI 特に ChatGPT を始めとする生成 AI サービスを活用する企業が増えつつあり、実際日本国内においても業種に関係無く様々サービスが提供されてきています。また、マイクロソフト社からは Azure OpenAI サービスが早々に提供され、エンタープライズ企業においてもこれらサービスを活用したアプリケーション開発の敷居が低くなりつつあります。

しかしながら ChatGPT などのサービスでは多くは Pay-as-you-Go 方式での費用体系となっており利用するモデルやトークンの消費量、利用する言語等にも依存するため、利用する前にどの程度の費用がかかるのか見積もることが困難なのが実情です。

例として中規模プロジェクトで日々の開発プロセスに ChatGPT を利用することを考えてみましょう。仮に約400行程のアプリケーションコードのチェックを1日に5回実施するとします。

入力テキスト

一度のチェックに消費するトークン: 5,000トークン

1000トークン辺りの費用(gpt-4): 0.03ドル

1日の消費トークン: 25,000トークン

年間の消費トークン: 9,000,000トークン

年間コスト(1人あたり): 270ドル

出力テキスト

一度のチェックに消費するトークン: 5,100トークン

1000トークン辺りの費用(gpt-4): 0.06ドル

1日の消費トークン: 25,500トークン

年間の消費トークン: 9,180,000トークン

年間コスト(1人あたり): 549.6ドル

合計すると年間で1人あたり約 819.6ドル(約 12万円)ほど、約 1,000人のエンジニアが利用すると約 819,600ドル(約 1.2億円)もの膨大なコストがかかってしまいます。(為替レート 2023年11月時点で算出)

そのため、OpenAI を活用する際は継続的に使用量を観測し今どのモデルがどれほどコストがかかっているのか? 想定外の利用があった際にどのように抑止していくのか? といった点も利用の際には考慮が必要です。

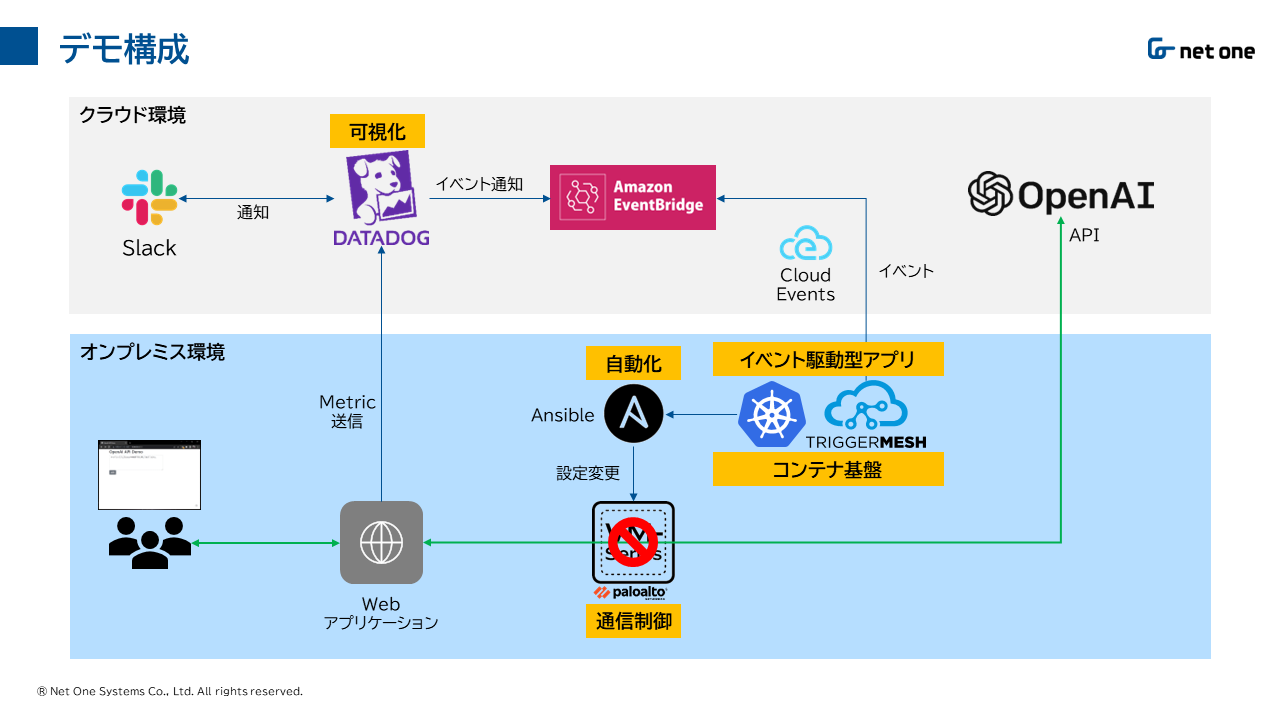

そこでネットワンでは

1. OpenAI 利用状況の観測

2. ハイブリッド環境でのシームレスなデータ連携

3. IaC による利用の抑止

といった大きく3つのソリューションを組み合わせて OpenAI の過剰利用を抑止するデモを構築しました。

OpenAI 利用状況の観測

近年では監視サービスを提供する各社でも OpenAI の監視機能を提供しており、多くは APM(Application Performance Monitoring) として OpenAI API を利用する Web アプリケーションから情報を取得しています。APM として情報取得することで OpenAI を利用しているアプリケーション毎に消費しているトークン数や API リクエストの処理時間、エラー率といった詳細まで取得することができ、これらのメトリックを元にコストを算出、該当アプリケーションの最適化を行うといったことが可能になります。

そこで本デモにおいてはサンプルとなる Web アプリケーションを用意し SaaS として監視サービスを提供している Datadog を用いてそれらの情報を取得しています。Datadog ではサンプルアプリケーションからプロンプトで利用されているトークン数を取得、過剰な利用があった場合にアラートを発報、Slack への通知を行い、それ以上の API 利用を許可するか停止するかといった判断を促します。

ハイブリッド環境でのシームレスなデータ連携

SaaS として提供されているサービスにおいては SaaS ゆえすぐに利用できる、拠点を問わず利用できるといったメリットがあるものの、いざオンプレミス環境と連携させようとすると多くは SaaS とオンプレミス環境間の通信に制限があり、Webhook などのアラートを起因としたアクション実行に難があります。

そこで本デモでは AWS EventBridge、TriggerMesh といったイベント駆動型のアーキテクチャを採用することで SaaS/オンプレミスでのシームレスなデータ連携を実現しています。

具体的には前述した "API 利用の許可/停止" といった判断内容をイベントとしてオンプレミス環境に転送するために一度 Datadog から AWS EventBridge に対してイベントを発行し、オンプレミス環境の TriggerMesh が EventBridge に対してイベントを取得しにいくことでオンプレミス環境下にリアルタイムにイベント情報を渡すことを実現しています。

前述したようなコストの可視化・分析といった観点では中長期でのトレンド分析が主となりリアルタイム性は求められません。しかしながら、そこから導き出される意思決定やそれを元にした具体的なアクションにはこのようなリアルタイムかつシームレスなデータ連携が求められるでしょう。

IaC による利用の抑止

オンプレミス環境では Ansible プレイブックとしてファイアウォールでの通信を許可/停止する2種類のプレイブックを用意しており、TriggerMesh は取得したイベントの内容からどちらのプレイブックを実行するべきか判断し必要に応じたプレイブックを実行、Web アプリケーションから OpenAI への API リクエストを抑止します。

また、同様にファイアウォールにて抑止した内容を解除したい場合も前述の AWS EventBridge や TriggerMesh を介して許可イベントを発行することで自動的にファイアウォールの抑止解除を実施しオペレーションの省力化を実現しています。

今後の展望

現在、ネットワンでも 独自 LLM の開発に着手 しておりますが企業における AI 活用が進むにつれ今回とりあげたようなコスト、セキュリティ等の様々な課題が見えてくることと思います。弊社としても AI 技術の活用だけではなくその過程で得られた運用ノウハウを蓄積するとともにステークホルダーの皆様に展開していきたいと思います。

※本記事の内容は執筆者個人の見解であり、所属する組織の見解を代表するものではありません。